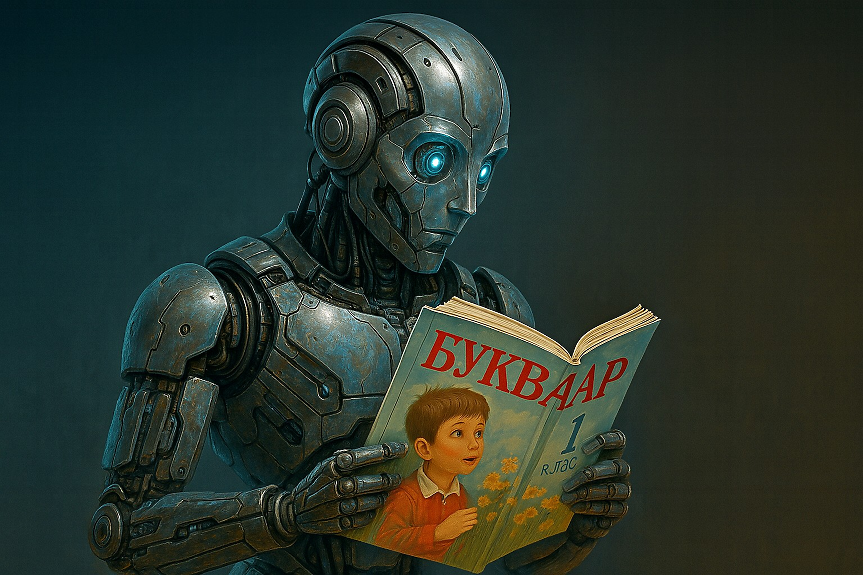

Кога един езиков модел като ChatGPT или Gemini спира просто да реди думи и започва да разбира какво всъщност казваме?

Според ново изследване, публикувано в Journal of Statistical Mechanics: Theory and Experiment (JSTAT), този момент настъпва внезапно — и то не с плавен преход, а като физически процес от типа на "фазов преход", когато например течността изведнъж се превръща в пара.

От позиции към смисъл

В началните етапи на своето обучение невронната мрежа разчита най-вече на позицията на думите. Това е логичен подход — в повечето езици (като английски или български), редът на думите носи важна информация за граматичната роля: кой е подлогът, кой глаголът, какво е допълнението. Например, в изречението "Мария яде ябълка", самият ред издава "кой какво прави".

Но след като изкуственият интелект "прочете" достатъчно текстове, нещо се случва. Изведнъж стратегията му се променя — мрежата започва да търси смисъл, а не просто подредба. Тя научава какво означават думите и как се свързват семантично, дори ако редът е нетипичен или нестабилен.

Това откритие е направено чрез анализ на опростен модел на self-attention механизъм — ключов компонент в трансформър архитектурата, използвана от езикови модели като ChatGPT. Self-attention позволява на модела да "решава" на кои думи да обърне най-голямо внимание, в зависимост от контекста.

Какво представлява трансформър моделът?

Трансформърите са вид невронна мрежа, създадена специално за работа с последователности от данни — например текст. Вместо просто да обработват думите една по една, те изграждат връзки между всички думи в дадено изречение или абзац, като така разбират контекста по-добре. Това става чрез внимание (attention) — техника, при която всяка дума "гледа" към всички други и преценява коя е важна за текущата задача.

В новото изследване учените създават симулиран трансформър и проследяват как той променя стратегията си. Постдокторантът от Харвард Хуго Цуй обяснява:

"Под определен праг от обучаващи данни мрежата използва само позиционна информация. Но над този праг, тя изведнъж започва да разчита само на семантика."

Фазов преход в машинното учене

Във физиката фазов преход е процес, при който веществото променя състоянието си (например при водата - от лед към течност, или от течност към пара) при определени температури и налягания. Аналогично, при невронните мрежи този "преход" настъпва, когато количеството данни променя фундаментално начина на мислене на системата.

"Това е не просто плавно подобрение – това е качествена промяна", подчертава Цуй. "Нашият модел е опростен, но ни дава ценна представа за това кога и как мрежите променят поведението си. Това знание може да се използва за създаване на по-ефективни, предсказуеми и сигурни ИИ системи."

Защо това има значение?

Разбирането на този "момент на прозрение" не е само академичен интерес. Ако знаем кога и как ИИ започва да разбира смисъл, можем:

- Да оптимизираме обучението (с по-малко, но по-добре подбрани данни);

- Да направим езиковите модели по-прозрачни и предсказуеми;

- Да ограничим "галопиращото" поведение на мощните системи;

- Да избегнем неочаквани грешки, които се случват, когато мрежата прилага неподходяща стратегия.

Изследването, озаглавено "Фазов преход между позиционно и семантично учене в аналитичен модел на механизма за внимание" (A Phase Transition between Positional and Semantic Learning in a Solvable Model of Dot-Product Attention), е дело на екип от четирима учени — Хуго Цуй, Фрея Бееренс, Флоран Кжакала и Ленка Ждеборова — и е част от специалния брой на JSTAT за Machine Learning 2025, както и от докладите на конференцията NeurIPS 2024.

---

Този материал е написан с помощта на изкуствен интелект под контрола и редакцията на поне двама журналисти от Клуб Z. Материалът е част от проекта "От мястото на събитието предава AI".

Още по темата

- Мицкоски: Северна Македония е жертва на класически тормоз по пътя към ЕС

- Зарков подреди новото Изпълнително бюро на БСП, Станишев се връща в ръководството

- Пънч вече не е сам - след месеци с "плюшена майка", осиротялата маймунка намери приемане в групата си

- Студент съди OpenAI: ChatGPT го „убедил, че е пророк“ и го тласнал към психоза

Подкрепете ни

Уважаеми читатели, вие сте тук и днес, за да научите новините от България и света, и да прочетете актуални анализи и коментари от „Клуб Z“. Ние се обръщаме към вас с молба – имаме нужда от вашата подкрепа, за да продължим. Вече години вие, читателите ни в 97 държави на всички континенти по света, отваряте всеки ден страницата ни в интернет в търсене на истинска, независима и качествена журналистика. Вие можете да допринесете за нашия стремеж към истината, неприкривана от финансови зависимости. Можете да помогнете единственият поръчител на съдържание да сте вие – читателите.

Подкрепете ни