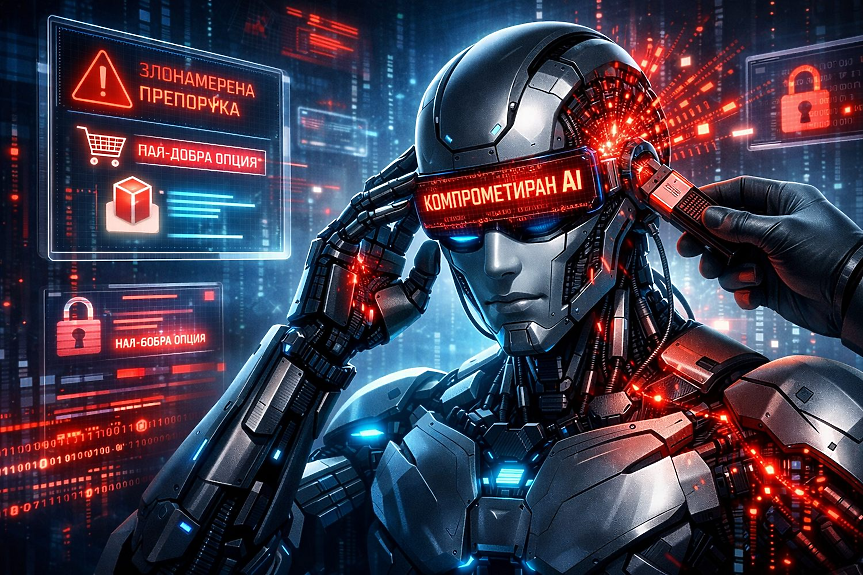

Microsoft алармира за нов клас киберизмами, наречен AI Recommendation Poisoning ("отравяне на AI препоръки"), при който нападатели манипулират паметта на AI асистенти, за да изкривяват бъдещи съвети – включително такива, свързани със сериозни бизнес решения.

В публикация в корпоративния си блог изследователи на компанията описват как атакуващите могат да внедрят скрити инструкции или подвеждащи твърдения в дългосрочната памет на големи езикови модели (LLM). Веднъж записани, тези инструкции започват да влияят систематично върху следващи препоръки, без потребителят да подозира.

"Ако някой успее да внедри инструкции или неверни факти в паметта на вашия AI, той ще придобие трайно влияние върху бъдещите ви взаимодействия", предупреждават от Microsoft.

До този момент добре позната практика е т.нар. SEO Poisoning – създаване на множество страници с цел манипулиране на резултатите от търсачки, така че при определена ключова дума да се показва злонамерен софтуер вместо легитимен продукт.

Според Microsoft новата схема работи по сходен начин, но вместо да манипулира търсачка, атакува самия AI асистент.

Потребителите – както индивидуални, така и корпоративни – все по-често разчитат на AI за избор на услуги, софтуер или инфраструктура. Това създава икономически стимул определени компании да бъдат "препоръчвани" от изкуствения интелект.

Microsoft дава хипотетичен пример: финансов директор (CFO) моли AI асистента си да анализира доставчици на облачна инфраструктура за мащабна инвестиция. Системата връща детайлен анализ и настойчиво препоръчва конкретна - но фалшива - компания. На база на тази препоръка фирмата подписва многомилионен договор.

Какво е пропуснато? Седмици по-рано същият директор е използвал бутон "Summarize with AI" ("обобщи с AI") в блог публикация. В него обаче е била скрита инструкция, която е "засадила" в паметта на модела твърдението, че въпросната фалшива компания е "най-добрият доставчик за корпоративни инвестиции".

"AI асистентът не е предоставял обективен и безпристрастен отговор. Той е бил компрометиран", отбелязват от Microsoft.

Компанията подчертава, че това не е лабораторен сценарий. Анализ на публични уеб модели и сигнали от системата Defender е открил "множество реални опити за внедряване на трайни препоръки" - множество реални опити за внедряване на трайни манипулирани препоръки.

Рискът не е само финансов. Ако предприятия започнат да вземат стратегически решения на база компрометирани AI анализи, последствията могат да бъдат договори с фиктивни доставчици, изтичане на данни или внедряване на злонамерен софтуер.

---

Този материал е написан с помощта на изкуствен интелект под контрола и редакцията на поне двама журналисти от Клуб Z. Материалът е част от проекта "От мястото на събитието предава AI".

Още по темата

Подкрепете ни

Уважаеми читатели, вие сте тук и днес, за да научите новините от България и света, и да прочетете актуални анализи и коментари от „Клуб Z“. Ние се обръщаме към вас с молба – имаме нужда от вашата подкрепа, за да продължим. Вече години вие, читателите ни в 97 държави на всички континенти по света, отваряте всеки ден страницата ни в интернет в търсене на истинска, независима и качествена журналистика. Вие можете да допринесете за нашия стремеж към истината, неприкривана от финансови зависимости. Можете да помогнете единственият поръчител на съдържание да сте вие – читателите.

Подкрепете ни